ダークウェブ上でChatGPTやほかの大規模言語モデル(LLM)の悪用に関する投稿は3,000件近くに上り、盗まれたChatGPTアカウントの販売や無料のChatGPTアカウントの自動作成サービスに関する投稿もおよそ3,000件に達しています。

[本リリースは、2024年1月24日にKasperskyが発表したプレスリリースに基づき作成したものです]

KasperskyのDigital Footprint Intelligence部門は、ダークウェブ上でChatGPTやほかの大規模言語モデル(LLM)の悪用に関する投稿を3,000件近く確認しました。サイバー犯罪者たちは、ダークウェブ上でチャットボットのような手段の構築や、あらかじめデバイスに設けられた制限を不正に解除するジェイルブレイク(脱獄)を実行するプロンプトセットの提供ほか、さまざまなスキームを模索しています。また、ダークウェブ上のフォーラムでは、盗まれたChatGPTアカウントの販売や無料のChatGPTアカウントの自動作成サービスもあふれており、これらに関する投稿もおよそ3,000件に達しています。

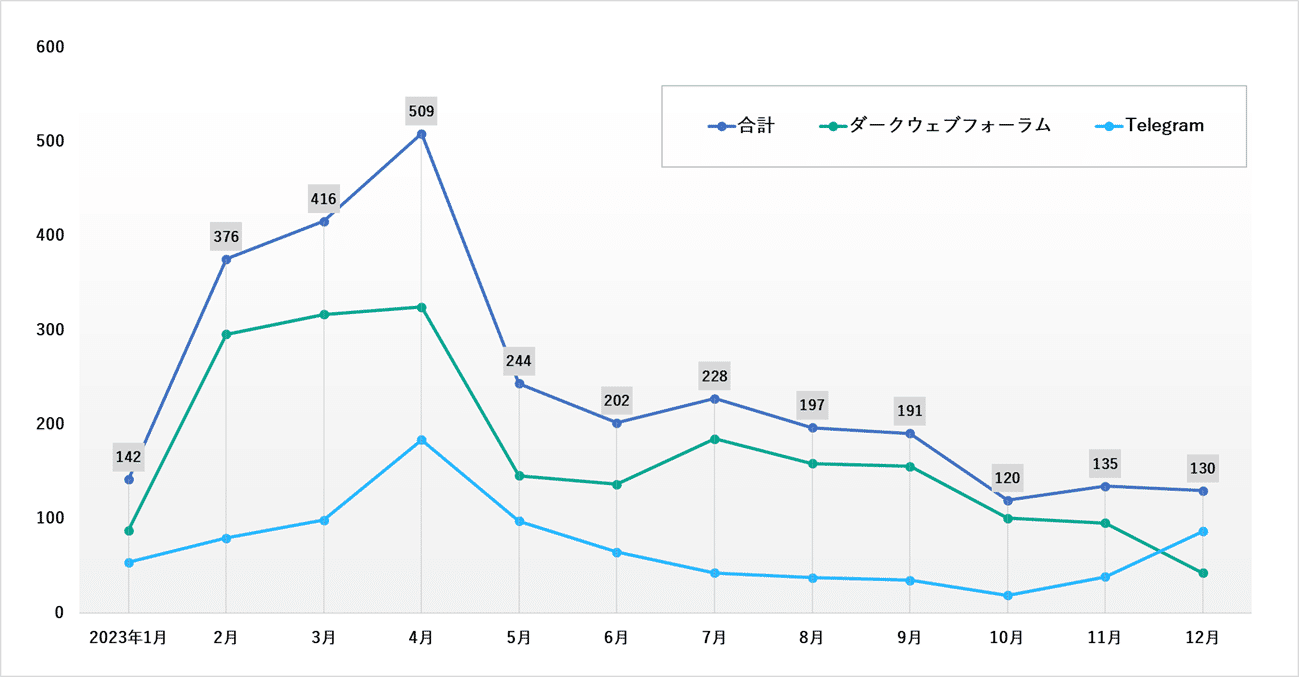

当社のDigital Footprint Intelligence部門のエキスパートは、脅威モニタリングサービス「Kaspersky Digital Footprint Intelligence」を使用して、ダークウェブ上で2023年に違法目的でのChatGPT使用やAI技術を使用したツールに関する投稿について調査しました。その結果、合計で3,000件近くの投稿が確認できました。投稿は4月にピークを迎え、その後減少傾向にありますが、まだ継続しています。

ChatGPTやほかのAIツール使用に関するダークウェブ上の投稿数の推移

ChatGPTやほかのAIツール使用に関するダークウェブ上の投稿数の推移

(データはKaspersky Digital Footprint Intelligenceより)

Kaspersky Digital Footprint Intelligence部門のアナリスト、アリサ・クリシェンコ(Alisa Kulishenko)は現状を次のように説明します。「攻撃者は、ChatGPTとAIを実装するためのさまざまなスキームを模索しています。よく話題になるのは、マルウェアの開発や違法な方法での言語モデルの使用であり、その例には盗まれたユーザーデータの処理や感染したデバイスのファイル解析などがあります。AIツールの普及により、ChatGPTなどによる自動応答がサイバー犯罪フォーラムに取り込まれるようになっています。攻撃者は、さまざまなダークウェブチャンネルを介してジェイルブレイクを可能にする特別なプロンプトセットの共有や、正規の侵入テスト用ツールを悪用する方法を編み出そうとしています」

チャットボットやAI以外にも、「XXXGPT」「FraudGPT」などに注目が集まっています。ダークウェブ上でChatGPTに代わる手段と見なされているこれらの言語モデルは、追加機能を備えており、オリジナルの使用制限もありません。

盗まれたChatGPTアカウントの販売

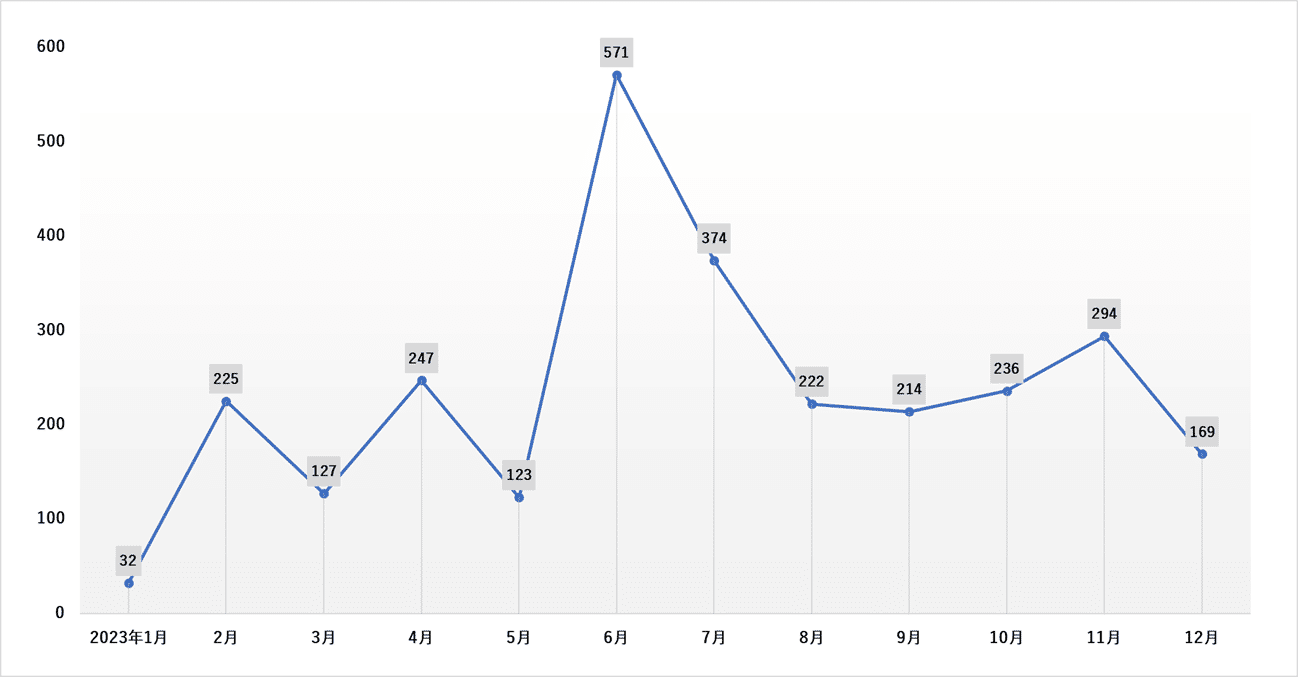

個人と企業にとってもう一つの脅威となるのが、ChatGPTの有料版アカウントを扱うダークマーケットです。2023年、ダークウェブとTelegramのシャドーチャンネルで、ChatGPT有料版アカウントの販売を宣伝する投稿を3,000件近く確認しました。こういった投稿には、盗まれたアカウントを販売するものと、要求に応じて大量にアカウントを作成する自動登録サービスを売り込むものがあります。特に一部の投稿は、複数のダークウェブ上のチャンネルに繰り返し公開されていました。

盗まれたChatGPTアカウントや自動登録サービスに関するダークウェブ投稿数の推移

盗まれたChatGPTアカウントや自動登録サービスに関するダークウェブ投稿数の推移

(データはKaspersky Digital Footprint Intelligenceより)

前出のアリサ・クリシェンコは次のように述べています。「AIツール自体は本来危険なものではありませんが、サイバー犯罪者は言語モデルの効率的な利用方法を見つけ出そうとしています。それによって、サイバー犯罪への参入障壁が下がる傾向が強まり、サイバー攻撃の件数が増える可能性があります。ただし、少なくとも2024年の段階では、生成AIとチャットボットによって攻撃の状況が一変する可能性は低いでしょう。サイバー攻撃はその性質上、自動化されているため、防御も自動化することになりがちですが、企業のサイバーセキュリティに関して攻撃者に先んじるには、その行動を常に把握しておくことが非常に重要です」

■ 当調査の詳細は、Digital Footprint Intelligence部門ブログ「Shadowy innovation: how cybercriminals experiment with AI on the dark web」(英語)でご覧いただけます。